-

老师好,请教一个基础问题,请问 ML 的相关知识在 RL 的使用中要掌握到哪种程度呢?

看一些 RL 基础代码库里面对于 DL 的利用都是比较固定的套路,所以对于套路之外的东西不甚了解,在面相关岗位/读博对 ML 的要求会和做其他 DL 方向的要求类似吗?

谢谢 😂

感谢这位同学的提问,恭喜获赠书籍!RLChina 强化学习社区后续会送出,请在 9 月 15 日前发送您的社区昵称、注册邮箱、姓名、电话和寄送地址至官方邮箱 rlchinacamp@163.com

-

PAC 定理是如何应用到实际中的呢?设定一个误差值得到一个样本数,这个样本个数是指有效样本的个数嘛?以及用这个样本训练真的能得到设定的误差值嘛?

感谢这位同学的提问,恭喜获赠书籍!RLChina 强化学习社区后续会送出,请在 9 月 15 日前发送您的社区昵称、注册邮箱、姓名、电话和寄送地址至官方邮箱 rlchinacamp@163.com

-

老师好,烦请您推荐一下图神经网络、多模态学习方向国内外近年来成果很丰富的组或者教授,谢谢!

-

老师好,对于 TF2.7 和 Pytorch 都要使用的 GPU 加速的情况下,两者对应的 cudnn 版本都不是太统一,所以问下老师有没有这方面的解决办法。

-

老师好,请教一个基础问题,请问 ML 的相关知识在 RL 的使用中要掌握到哪种程度呢?

看一些 RL 基础代码库里面对于 DL 的利用都是比较固定的套路,所以对于套路之外的东西不甚了解,在面相关岗位/读博对 ML 的要求会和做其他 DL 方向的要求类似吗?

谢谢 😂

感谢这位同学的提问,恭喜获赠书籍!RLChina 强化学习社区后续会送出,请发送您的姓名电话和寄送地址至官方邮箱 rlchinacamp@163.com

-

PAC 定理是如何应用到实际中的呢?设定一个误差值得到一个样本数,这个样本个数是指有效样本的个数嘛?以及用这个样本训练真的能得到设定的误差值嘛?

感谢这位同学的提问,恭喜获赠书籍!RLChina 强化学习社区后续会送出,请发送您的姓名电话和寄送地址至官方邮箱 rlchinacamp@163.com

-

老师您好,我现在在做音乐推荐系统,并且数据是自己设计用户实验找受试收集的,想要设计一个可论证的结果,这个用户量应该至少需要多少呢?每个用户又至少需要产生多少个数据量?

-

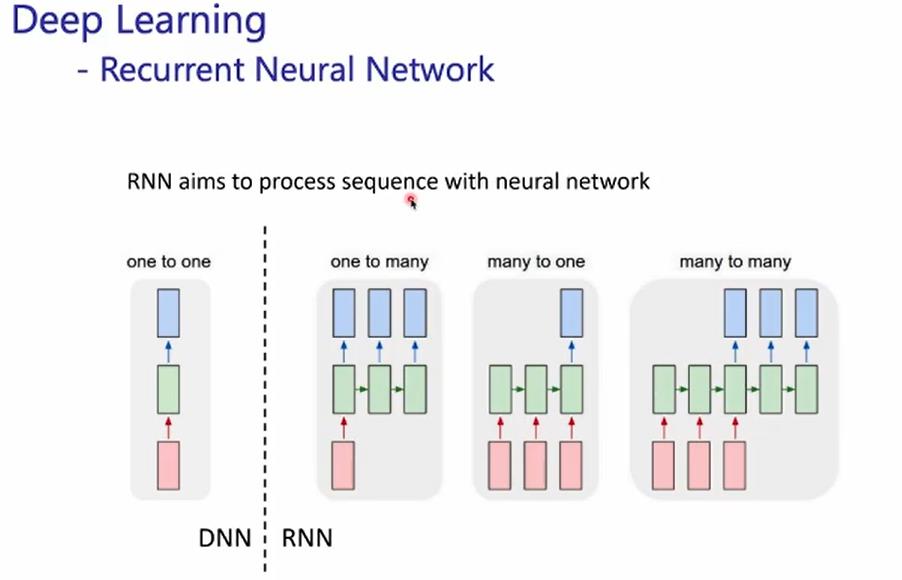

针对 RNN 是每读取一个新的输入 Xt,就会生成状态向量 ht 作为当前时刻的输出和一下时刻的输入状态,那么 T 个时刻的输入以此输入 RNN,相应的会产生 T 个输出,也即是输入和输出序列长度必定是相同的,可是课堂上陈旭老师给到的这张课件中提到的是有多种形式,比如一对多,多对一,多对多,意思是说 RNN 算法有针对不同的形式有不同的模型吗?比如 seq2seq 模型适合解决多对多这样?

-

老师,辅助神经网络在强化学习训练数据有很大的优势吧?谢谢

-

请问 更新推荐系统的 r,q,更新时也是类似多层网络那样求对 r,q 的梯度吗

-

老师,DRL 结合 GNN 做控制优化有可行性吗?

-

老师,推荐系统现阶段的评价指标用哪几个比较多?

-

老师,您好,请问我们利用强化学习来对建立的模型进行了训练和测试,对其结果进行评价,评价结果理想的话,下一步应该怎么去应用呢?

-

老师你好,想请问一下目前推荐系统算法里面精度最高的是哪个呢?有具体的论文吗?

-

老师您好,目前推荐系统 + 强化学习的结合,有哪些值得探索的方向呢?

-

老师好,请教一个基础问题,请问 ML 的相关知识在 RL 的使用中要掌握到哪种程度呢?

看一些 RL 基础代码库里面对于 DL 的利用都是比较固定的套路,所以对于套路之外的东西不甚了解,在面相关岗位/读博对 ML 的要求会和做其他 DL 方向的要求类似吗?

谢谢 😂

一会帮你问一下~

-

您好,强化学习现在应用到哪些方向呢?和监督学习比较,优势 or 区别是什么呢

一会帮你问一下~

-

PAC 定理是如何应用到实际中的呢?设定一个误差值得到一个样本数,这个样本个数是指有效样本的个数嘛?以及用这个样本训练真的能得到设定的误差值嘛?

一会帮你问一下~

-

老师你好,我想请问一下,您觉得强化学习在自动驾驶领域的发展怎么样?如果想要深入了解这一方面,老师有没有推荐的文献资料或者课程?谢谢老师

-

陈老师好,我是电子科技大学的准研一学生,研究方向为强化学习和联邦学习(博弈论视角)。非常荣幸能听到老师这次讲座。在这里我有两个个人认为比较有价值的问题想请教一下老师。

第一:众所周知,强化学习由于其和环境交互的激励机制,与我们人类大脑的奖惩机制有一些异曲同工之处,以强化学习之父 Richard Sutton 为代表的一众学者也认为强化学习是我们通往通用人工智能 AGI 的一条路径,而 DeepMind 公司的一些科研工作例如 AlphaGO 也在实践上将这一理念在一定程度上变成了现实。另外值得一提的是,当前也有一部分学者在做将强化学习和一些演化计算等基于生物智能的方法结合的研究工作。所以,我想请教一下老师您如何看待“强化学习通往 AGI”这一路径,是否值得探索?以及如果可行的话,您又认为强化学习和类脑计算以及演化计算等生物智能的方式结合能擦出什么样的火花?

第二:当前很多强化学习的工作方式还局限在例如游戏 AI 等情景的封闭环境当中,在很多开放环境下还不是特别适用,而南京大学的俞扬教授等学者也认为强化学习当前最大的阻碍是落地难的问题,所我想请教一下老师强化学习破解这一瓶颈有哪些值得探索的方式?

再次感谢老师。 -

老师您好,神经网络 Hidden Layers 深度和宽度如何取舍,有什么较为通用的依据么

-

请问有哪些网站/期刊可以看到 rl 的应用

-

感谢陈老师精彩的报告,有以下问题想请教陈老师:

我是土木工程专业的,目前看到的人工智能应用到土木工程的论文里面,关于 dataset 和 inputdata 两部分的分布一致问题,以及 trainingset 和 testing set 分布一致的问题提到得很少。如果不对这两类数据集之间的分布一致性进行处理和干涉,直接进行机器学习模型训练,结果是否可靠呢? - 老师,您好,机器学习怎样才能学好,有没有比较好的书籍和公众号推荐?

-

老师你好,我想问一下以目前的研究成果来看,深度学习的效果是要强于传统机器学习的,那么真的能说明深度学习可以取代传统机器学习吗,传统机器学习模型还可以在什么方面有所突破?

-

陈老师您好,我想请问一下您如何看待强化学习落地难,现在大多应用于游戏场景的问题呢?除了仿真环境的问题外,您觉得还有哪些重大问题是有待突破的呢?谢谢!

-

老师 如何评价你的模型的泛化能力和损失函数建立的怎么样。

-

老师,我想问一下,对于强化学习这一方面,我在有了一定了解之后,想问一下,在设置惩罚项和奖励项的时候可以怎么样设计得更加复活逻辑?因为目前来看,我所了解到的奖赏项和惩罚项的设置好像都是比较受人为规定的

-

老师好,如果不知道数据服从什么分布怎么确定最小的样本数量,假设它是正态分布么?是不是数据在开始训练前都需要进行一个分布的查看,再去选择模型进行训练?

-

老师您好,请问模型空间 H 的容量 |H| 有明确的计算方法吗?

-

老师您好,我想请问一下刚刚讲的关于样本复杂度的结论在实际上怎么应用啊?公式中有 hypothesis space H 的大小,这个量在实际应用中怎么知道呢?

-

PAC 定理是如何应用到实际中的呢?设定一个误差值得到一个样本数,这个样本个数是指有效样本的个数嘛?以及用这个样本训练真的能得到设定的误差值嘛?

-

老师您好,请问机器学习、强化学习等知识学到什么程度可以开始尝试去跑项目?

-

陈老师,您好,transformer 目前在视觉、语音和强化学习上都有比较广泛的应用,且效果良好,大有一统的趋势,请问什么时候我该使用 transformer?还是说只能尝试一下看看效果

-

老师您好,想问一下 PAC learning 中,能完全预测 D,但是过拟合的 h 也算是 consistent 吗?

-

陈旭老师,请问强化学习应用于推荐系统或者自动驾驶等方向有啥区别,各自的侧重点是啥?目前应用于推荐系统的方法有很多,那么强化学习相比于其他的算法有什么优势呢?对于入门强化学习有什么建议么

-

老师您好,请问强化学习在目标追踪领域有没有优势,能否有更好的发展

-

请问目前强化学习落地方面除了做游戏方面还有什么落地场景吗?目前老师对强化学习应用于推荐系统或者自动驾驶等方向看法如何?目前应用于推荐系统的方法有很多,强化学习相比于其他方法有什么优势呢?

-

陈老师,请问一下。强化学习在 sample complexity 方面有什么成系统的 书籍 或者 survey 推荐的吗?

感觉强化学习的 sample comlexity 应该会更难一些?因为样本不是严格 independent 的? -

陈老师您好,我是广西科技大学的一名计算机硕士研究生,想请教一下陈老师,在 few-shot 或者是 zero-shot 领域,我们的 Machine learning、Deep learning 以及 Reinforcement learning 训练方法过程上需要有什么调整变化吗?或者说是这些方法是如何解决这领域问题的?

-

请问 sutton 和 Lapan 的书需要都学吗?

-

您好,强化学习现在应用到哪些方向呢?和监督学习比较,优势 or 区别是什么呢

-

想请教一下陈老师:现在深度学习的方法已经有了很多发展,但是在很多的 AI 比赛中,有相当多获得高分的选手使用的却是像决策树等比较经典的机器学习方法,想问下陈老师对这种情况是怎么看的?是深度学习方法在实际应用中存在某种局限性吗?还是说很多比赛的数据集都太过特殊了?

- 老师,想咨询下,需要学习哪些先导课程,再参与咱们的课程更合适 (个人在入门阶段,诚心请教,感谢老师~)

-

想问下老师,在机器学习的训练中如何去除一些异常的数据点?选择的标准是什么?标准是否有训练集和测试集之分?

RLChina

RLChina 是由国内外强化学习学者联合发起的民间学术组织,主要活动包括举办强化学习线上公开课、强化学习线上研讨会等,旨在搭建强化学习学术界、产业界和广大爱好者之间的桥梁。

评论(71)

请

登录后发表观点